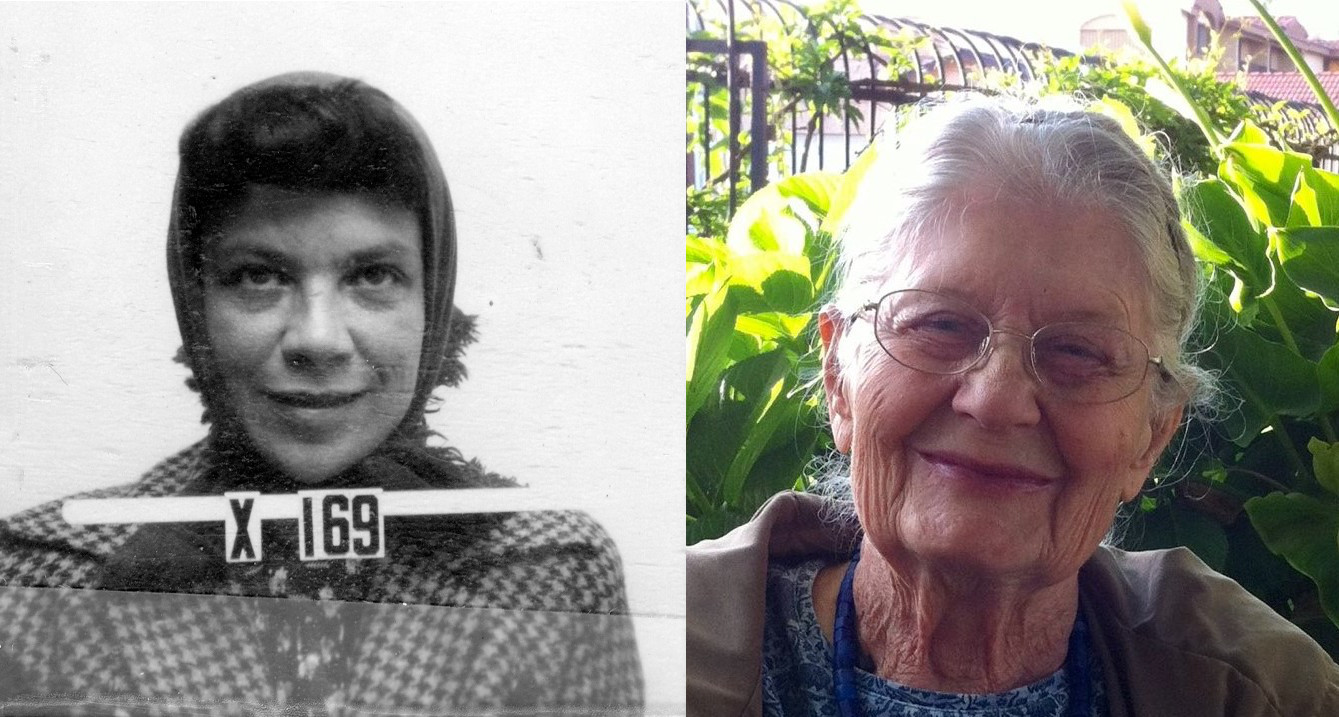

Terminaron las clases teóricas de la materia. Hace tres años, durante la pandemia, decidí que un tema que no suele discutirse explícitamente en el aula (aunque sí implícitamente), debía ser discutido abiertamente. Estoy hablando de la ética científica, y de una forma de encarar y atacar los problemas que encontramos, de entender qué pueden responder nuestros conocimientos y qué no, y de aceptar nuestros errores y limitaciones. Y aquel cuatrimestre, al terminar el curso, escribí una carta a todos los estudiantes que en buena medida (pero con algunas actualizaciones considerando a este curso en particular) reproduzco a continuación.

Todavía hoy se sienten los efectos educativos de la pandemia. No voy a ocultar mi opinión sobre la importancia de la presencialidad en la educación universitaria: el aula real (como oposición al aula virtual) permite tener discusiones y una serie de preguntas y respuestas abiertas, espontáneas e impredecibles que no pueden ocurrir mirando videos online de clases grabadas. Como profesor, la presencialidad me permite saber mejor qué temas están entendiendo y cuáles no durante las explicaciones. La presencialidad expone mejor qué temas están flojos, cuáles requieren refuerzos, y cuáles se comprenden. El aula le permite a ustedes interactuar de otra forma con los docentes del curso, sacarse dudas, y corregir errores. No voy a negar la comodidad de mirar las clases desde sus casas, o de escuchar explicaciones a la hora más conveniente. La pandemia trajo cambios al aula que son valiosos, y el día que no pueden asistir a clases el material disponible online es útil para que no se atrasen. Pero hay una combinación razonable de ambas modalidades que puede funcionar para el aprendizaje, y este cuatrimestre eso se notó fuertemente.

Tan importante como esto es el hecho de que la presencialidad también permite que, solo con la gestualidad o en la forma en la que los docentes explicamos o reaccionamos a ciertas preguntas, podamos enseñar más cosas que las que aparecen en el pizarrón, o al menos intentarlo. Porque hay un conjunto importante de conocimientos que no forman parte explícita de los contenidos de las materias, pero que se aprenden informalmente, y que no pueden compartirse ni enseñarse si no se hace en forma presencial.

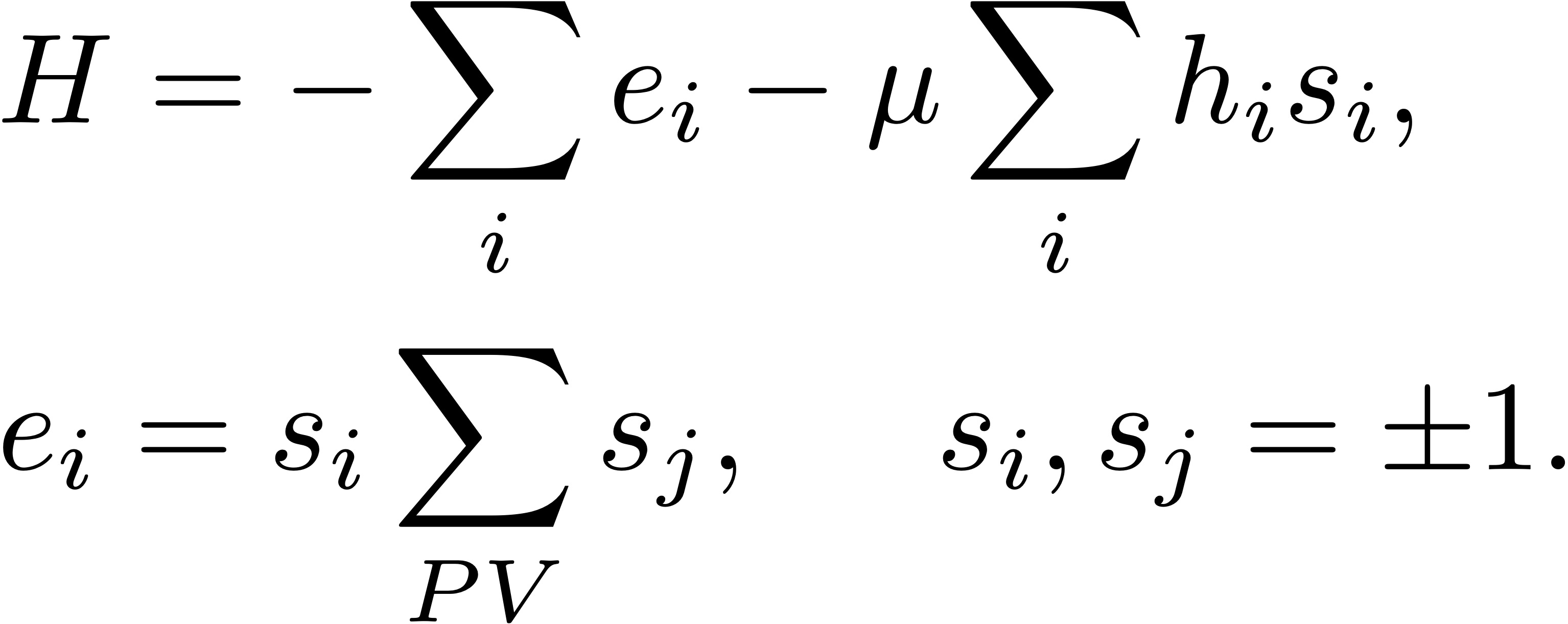

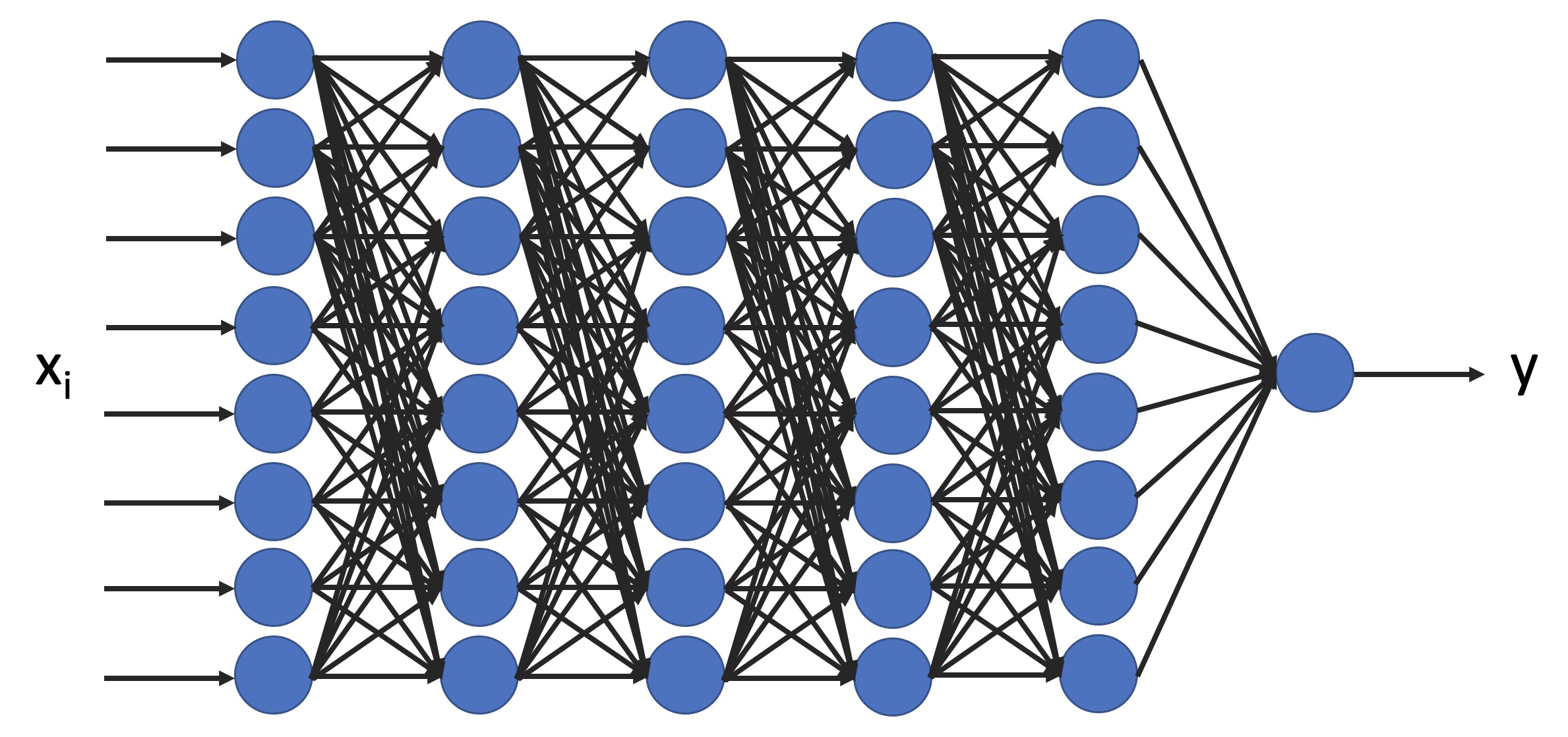

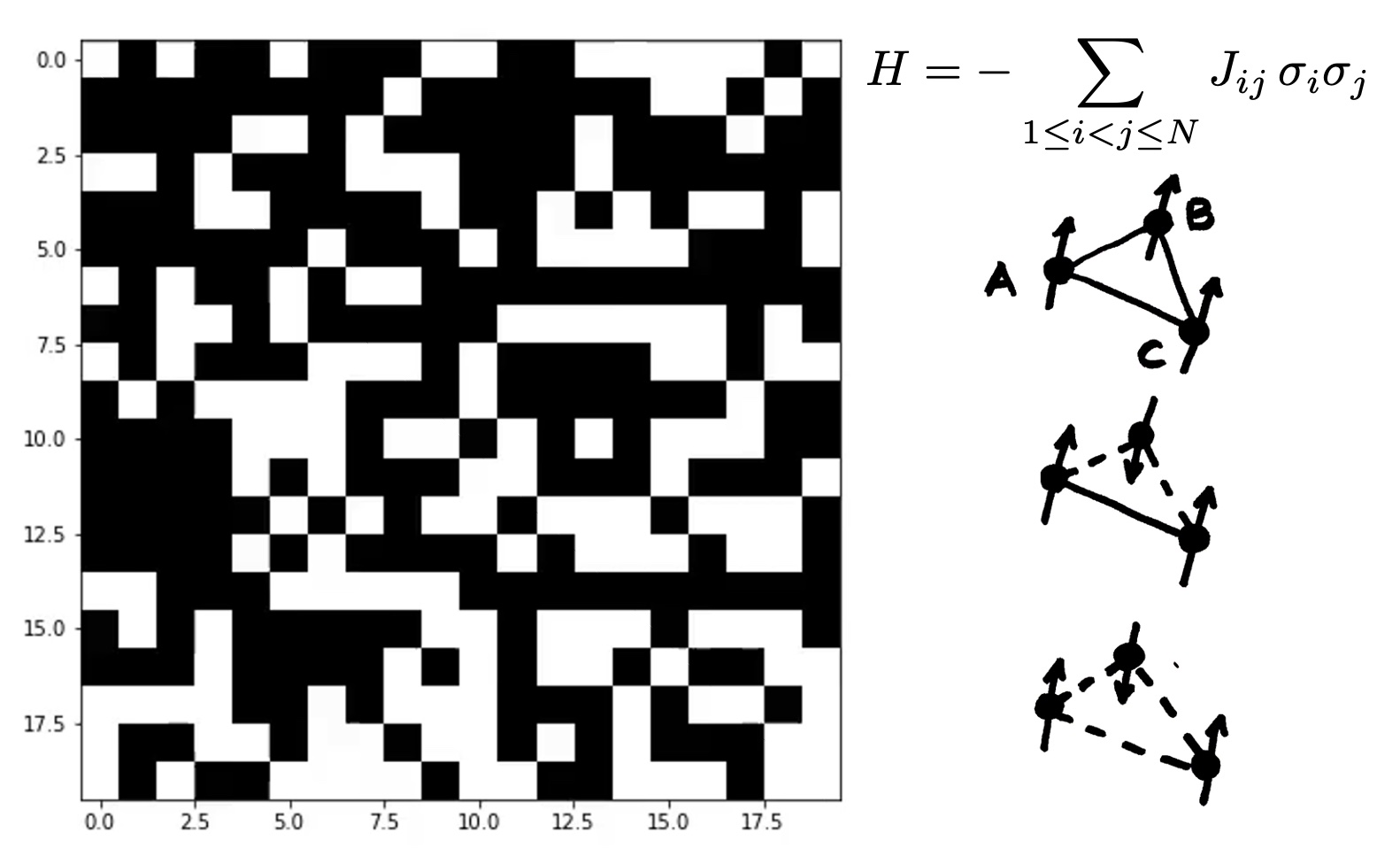

Existe un conjunto de normas, una ética científica, que esperamos que aprendan a lo largo de la carrera. No hay una materia específica para esto, se aprende en los pasillos, en las conversaciones con compañeros y docentes, en indicaciones mínimas que se dan en el aula. Cuando cursaron Laboratorio 1, probablemente les dijeron que nunca debían falsificar o inventar un dato. Si rindieron finales presenciales, en algún final les habrá llamado la atención que los dejaron escribir sus notas solos: esperamos que sepan que en ciencia es inaceptable copiarse. En alguna materia les habrán dicho que es importante reconocer lo que uno no sabe, o los errores que uno comete. Y en esta materia, tan vasta en sus aplicaciones, uno de los contenidos no escritos es aprender los límites de lo que sabemos, las limitaciones de las aproximaciones, y cómo aplicarlas correctamente desde nuestro lugar como físicos. A lo largo de la materia vimos, en las clases o en la página web del curso, aplicaciones en economía, en biología y epidemias, meteorología, teoría de la información, cosmología, astrofísica, dinámica de fluidos, física de altas energías, y materia condensada. Es claro que las últimas aplicaciones pertenecen al área del conocimiento abarcada por la física. Algunas de las primeras no. Las herramientas de la materia sirven para estudiar (en forma parcial) a estos temas, y no está mal que los consideremos, y que tratemos de aprender cosas nuevas. ¿Pero significa eso que sabemos de esos temas? ¿O que podemos opinar como expertos?

Hace unos pocos años, la pandemia de COVID puso al sistema científico mundial, y a muchos científicos individuales en particular, en una disyuntiva similar. Y, a tono personal, puedo deciles que creo que muchos científicos no aprobaron el examen con éxito (de hecho, algunos en Argentina y en el mundo han protagonizado papelones importantes, dañando la credibilidad general de la ciencia). Tal vez ustedes en el futuro se encuentren en una situación parecida trabajando en la academia. O se encuentren trabajando para una empresa que evalúa riesgo bursátil o cualquier otra cosa para el sector privado, o colaborando con colegas de otras áreas en grupos interdisciplinarios. La tentación de usar un conjunto de herramientas que sabemos que funcionan en muchísimos casos para opinar como expertos es grande. Pero la ciencia a lo largo de los siglos generó un conjunto de buenas prácticas que nos guían sobre cómo debemos comportarnos en esas situaciones. Y nos enseñan a defender con seguridad lo que sabemos, pero también a escuchar a los expertos de otros temas en sus áreas del conocimiento. Y sobre todo, a comunicar (tanto a nuestros colegas, como al público general) primero lo que no sabemos, para luego poder informar responsablemente lo que aprendimos.

Esto probablemente sea aún más importante para las generaciones futuras de científicos, como ustedes. Que vivamos en una sociedad moderna, con problemas complejos, y en los que la ciencia juega un rol central, no significa que la ciencia o los científicos deban ser los instauradores de la verdad. En una sociedad democrática el rol de la ciencia es (entre otros) el de presentar datos y asesorar a la sociedad en la toma de decisiones, pero no tomar decisiones por ella, ignorar la opinión de otros expertos, ubicarse en una posición de privilegio, o perder su independencia a cambio de financiación. La lucha contra las noticias falsas no puede implicar acallar las opiniones, o negarlas solo con argumentos de autoridad. Y muchos menos puede autorizarnos a jugar con las mismas reglas que los que diseminan noticias falsas, y presentar datos parciales o editados con el fin de imponer una postura, por más convencidos de su validez que estemos. Esto no significa que ustedes no puedan o deban involucrarse en causas sociales, políticas, religiosas o culturales que los interpelen. Pero es importante aclarar desde qué lugar hablan en esos casos, y no mezclar sus deseos o creencias con el trabajo que puedan hacer o con la opinión que puedan dar como científicos. También es muy importante que entendamos cómo se genera el conocimiento científico, que comprendamos que en física no hay teoremas que nos den seguridad plena porque la física es una ciencia natural, y que la forma en la que creamos teorías se inicia en la observación y la experimentación, y se verifica con la predicción y la validación de esas predicciones.

En un famoso discurso Richard Feynman dijo que esperamos que los estudiantes aprendan todo esto en las aulas “por osmosis” (y probablemente esta sea la mejor forma). Se que a algunos estudiantes poner en discusión este tipo de cosas les gusta y a otros les molesta, pero creo que una parte importante del trabajo en el aula involucra justamente esto: enseñar, con las limitaciones que cada uno de los profesores tenemos, cómo se hace ciencia, cuáles son las buenas prácticas científicas, qué cosas no se hacen, qué cosas nos preguntamos, y cuales están fuera de nuestra área del conocimiento y son conversaciones de café. Esto incluye comprender la metodología de la física, el manejo honesto de los datos, aceptar el error, aprender a no engañarnos a nosotros mismos, no exagerar la relevancia de nuestros resultados, ser cuidadosos en la comunicación de la ciencia, no usar argumentos de autoridad, y muchas otras prácticas que son centrales para sostener la credibilidad de la ciencia en general, y de nuestro trabajo en particular.

Mucho mejor que cualquier otra cosa que yo pueda escribir sobre buenas prácticas científicas es leer ese famoso discurso de Feynman. Así que les recomiendo fuertemente que lean el discurso sobre ciencias, pseudo-ciencias y ética científica que Feynman dio a los graduados de Caltech en 1974:

Aunque todo su discurso no tiene desperdicio, solo voy a resaltar cuatro párrafos que me parecen relevantes, y que traduzco a continuación:

- “Esa es la idea que esperamos que hayan aprendido al estudiar ciencias: nunca les dijimos explícitamente cuál es, pero esperamos que lo hayan descubierto a partir de todos los ejemplos de investigación científica. Es interesante, por lo tanto, mencionarla ahora y hablar de esto explícitamente. Es un tipo de integridad científica, un principio de pensamiento científico que corresponde a un tipo de honestidad absoluta, y tomando distancia. Por ejemplo, si están haciendo un experimento, deben informar todo lo que creen que podría invalidarlo, no solo lo que creen que es correcto.”

- “El primer principio es que no debes engañarte a ti mismo, y eres la persona más fácil de engañar. Así que debes tener mucho cuidado con esto. Después de que no te hayas engañado, es más fácil no engañar a otros científicos.”

- “Me gustaría agregar algo que no es esencial para la ciencia, pero es algo que creo: no debes engañar a la persona común cuando hablas como científico. No estoy diciendo que no engañes a tu pareja cuando no estás tratando de ser científico. Esos son problemas para ustedes y sus rabinos. Estoy hablando de un tipo específico de integridad adicional que consiste no solo en no mentir, sino en hacer el esfuerzo de tomar distancia para mostrar cómo tal vez estás equivocado, y que debes hacer cuando actúas como científico. Y esta es nuestra responsabilidad, ciertamente para con los otros científicos, y también al hablar con la gente común.”

- “Así que solo tengo un deseo para ustedes: que tengan la buena suerte de estar en un lugar donde sean libres de mantener el tipo de integridad que he descrito, y donde no se sientan forzados a perder la integridad para mantener su posición en una organización, o el apoyo financiero, u otras cosas. Ojalá tengan esa libertad.”

Como dijo Ben Parker, “con grandes poderes vienen grandes responsabilidades” (y admitamos que saber contar microestados tampoco es un poder tan grande). No hagan daño, sean honestos, trabajen y esfuércense, colaboren, compartan con transparencia sus datos, piensen cómo usan el método científico, no sean soberbios, no usen argumentos de autoridad ni se proclamen expertos, aclaren cuándo hablan como científicos y cuándo desde sus creencias, digan siempre explícitamente cuáles son sus conflictos de interés, y no se pongan a ustedes mismos en situaciones en las que tengan que faltar a la ética científica.

Si esta es la última Física Teórica que cursan, y si no van a hacer la materia optativa que daré el próximo cuatrimestre, es probable que no nos volvamos a encontrar en un aula (al menos mientras sean estudiantes de grado). Les agradezco la paciencia en este cuatrimestre, y espero que hayan disfrutado la materia. Para mí, es la materia más linda de toda la carrera. Y a todo el resto, espero verlos nuevamente en algún aula. Mucha suerte en el parcial, y a todos los que aprueben los veré en el examen final. Cuídense, y no defrauden nunca a la vocación que los llevó a elegir una carrera científica.