En la película Spectral (disponible en Netflix), unos condensados de Bose-Einstein toman vida y congelan a las personas hasta la muerte. Por suerte, gracias al poder de la ciencia, pueden ser atrapados por materiales cerámicos y por el hierro, y por una pistola de pulsos que destruye al condensado (Yeah, science!). En el laboratorio hay pocas chances de que un condensado de Bose-Einstein cobre vida (pero por las dudas, no se acerquen al Laboratorio de Iones y Átomos Fríos del DF). Así que en este post vamos a ver cómo se ve un condensado en la realidad.

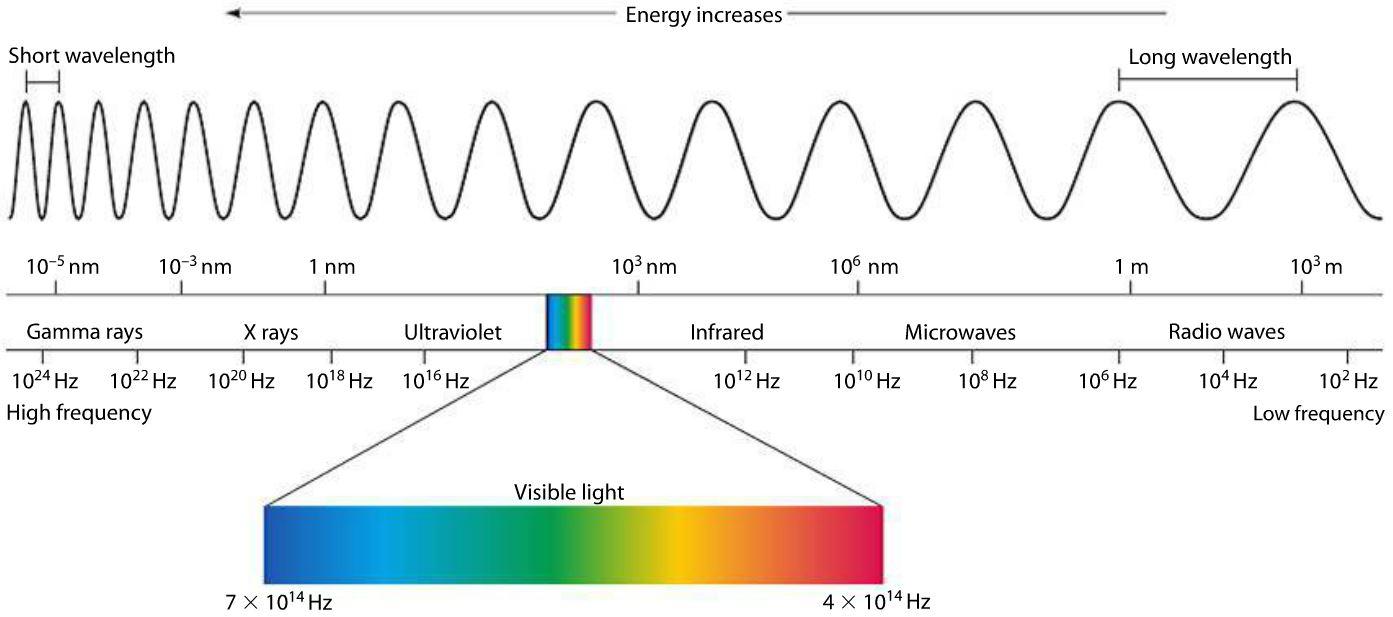

A continuación les dejo algunos videos sobre condensados de Bose-Einstein. Como los videos son largos, para aquellos que tienen síndrome de déficit de atención les digo también a qué instante pueden saltear para ver algunas cosas interesantes. Como mencioné en la última clase, recién en 1995 se realizaron los primeros experimentos de condensados de Bose-Einstein en gases diluídos de átomos ultrafríos, en los que la interacción entre los átomos es débil:

El video muestra un experimento con un gas de átomos de sodio. La descripción del experimento ocurre entre el minuto 0:46 hasta 2:50. A partir del minuto 3:10 hasta 3:50 pueden ver mediciones de la temperatura en el gas, y la formación del condensado de Bose-Einstein.

Los que tengan un poco mas de paciencia pueden ver la charla completa de Eric Cornell cuando recibió, junto con Carl Wieman y Wolfgang Ketterle, el premio Nobel por conseguir el primer condensado de Bose-Einstein gaseoso en el laboratorio:

Nobel Lecture by Eric A. Cornell

El video dura 39 minutos. Los que quieran pueden saltear la introducción e ir al minuto 5:23 hasta 7:03, donde Cornell explica el rol que juega la longitud de onda de de Broglie en la transición de fase (algo que vimos en las últimas clases). A partir del minuto 28:49, Cornell muestra imagenes de vórtices cuantizados en el condensado, un tema que veremos en la próxima clase. En el próximo post, videos de superfluidos escapándose espontáneamente de sus recipientes (¡seguro hay una película de ciencia ficción que usa este fenómeno!).

El video de la última cláse teórica, y los apuntes para la próxima clase, están disponibles acá. Y no se olviden de llenar la encuesta obligatoria, siguiendo las instrucciones en este post. ¡Si no la llenan, despídanse de la materia!

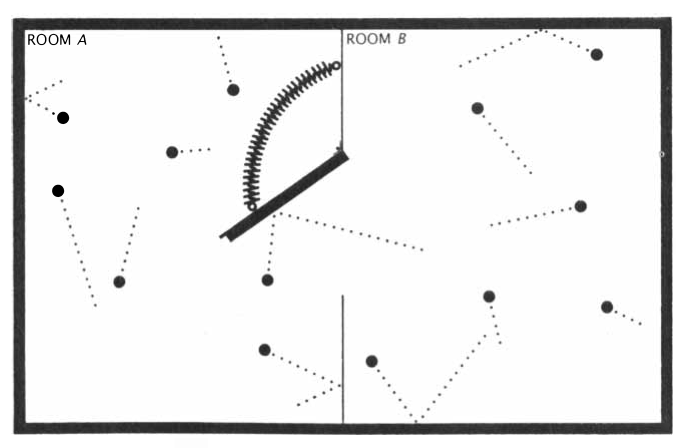

/cdn.vox-cdn.com/assets/1346999/alan_turing_monopoly.jpeg) Hace unos años, un grupo de científicos demostró que obtener ciertas propiedades macroscópicas a partir del conocimiento completo y preciso de las leyes microscópicas del sistema es

Hace unos años, un grupo de científicos demostró que obtener ciertas propiedades macroscópicas a partir del conocimiento completo y preciso de las leyes microscópicas del sistema es