En la película Spectral (no recomendada por esta materia), unos condensados de Bose-Einstein toman vida y congelan a las personas hasta la muerte. Por suerte, gracias al poder de la ciencia, pueden ser atrapados por materiales cerámicos y por el hierro, y por una pistola de pulsos que destruye al condensado (Yeah, science!). En el laboratorio hay pocas chances de que un condensado de Bose-Einstein cobre vida (pero por las dudas, no se acerquen al Laboratorio de Iones y Átomos Fríos del DF). Así que en este post vamos a ver qué es y cómo se ve un condensado en la realidad.

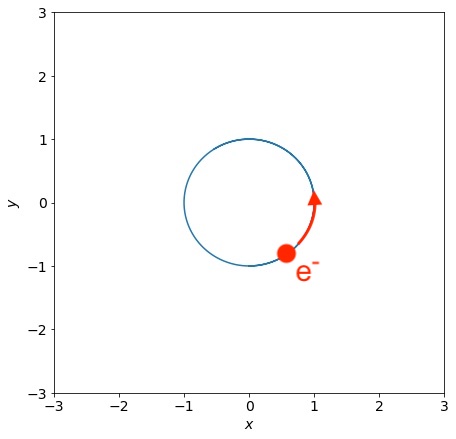

¿Qué es un condensado de Bose-Einstein? Comencemos por recordar que en la naturaleza toda la materia que conocemos se separa en dos tipos: fermiónica y bosónica. Los fermiones (como los electrones) satisfacen el principio de exclusión de Pauli: no podemos encontrar dos electrones en el mismo estado. Todos quieren ser diferentes. Los bosones (como los átomos de helio) tienen el comportamiento social contrario: no les molesta ser todos iguales, y estar todos juntos. Los fermiones escuchan jazz, los bosones son rolingas. Entonces, un gas de bosones (como los átomos de helio), muy frío, no se comporta como un gas clásico (es decir, como un montón de partículas separadas). Se comporta como si fuera una única partícula cuántica muy gorda, que puede tener tamaños que podemos observar a simple vista, pero que está descripta por una única función de onda. La noción de “átomos” como pelotitas independientes se borra. Y se borra en escalas macroscópicas: tenemos una bola de gas que actúa como un único objeto cuántico.

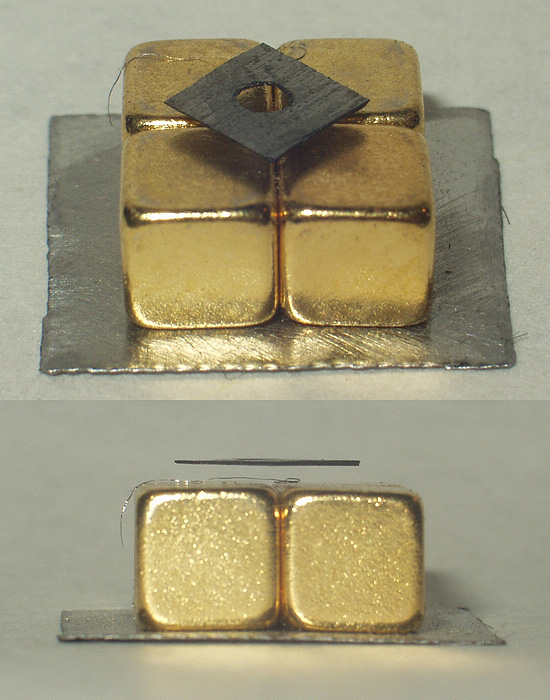

A continuación les dejo algunos videos sobre condensados de Bose-Einstein. Como los videos son largos, para aquellos que tienen síndrome de déficit de atención les digo también a qué instante pueden saltear para ver algunas cosas interesantes. Como mencioné en la última clase, recién en 1995 se realizaron los primeros experimentos de condensados de Bose-Einstein en gases diluídos de átomos ultrafríos, en los que la interacción entre los átomos es débil:

El video muestra un experimento con un gas de átomos de sodio. La descripción del experimento ocurre entre el minuto 0:46 hasta 2:50. A partir del minuto 3:10 hasta 3:50 pueden ver mediciones de la temperatura en el gas, y la formación del condensado de Bose-Einstein.

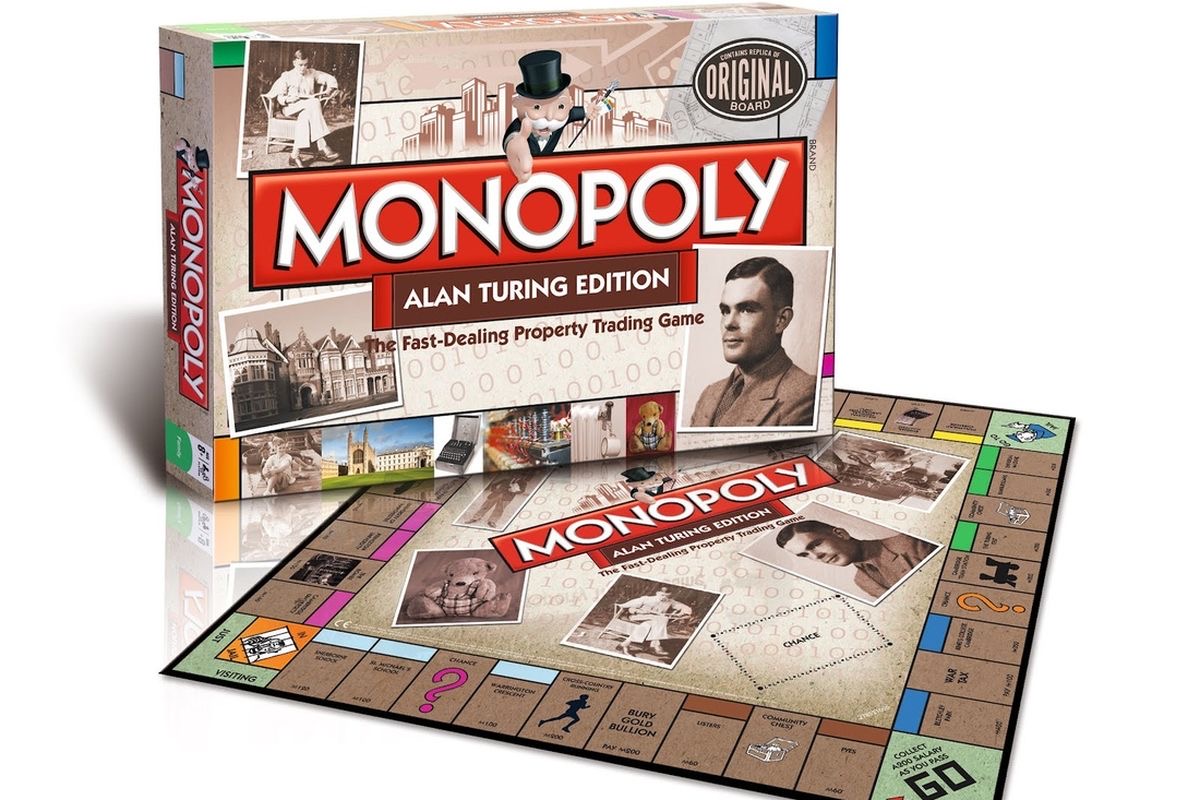

Los que tengan un poco mas de paciencia pueden ver la charla completa de Eric Cornell cuando recibió, junto con Carl Wieman y Wolfgang Ketterle, el premio Nobel por conseguir el primer condensado de Bose-Einstein gaseoso en el laboratorio:

El video dura 39 minutos. Los que quieran pueden saltear la introducción e ir al minuto 5:23 hasta 7:03, donde Cornell explica el rol que juega la longitud de onda de de Broglie en la transición de fase (algo que vimos en las últimas clases). A partir del minuto 28:49, Cornell muestra imagenes de vórtices cuantizados en el condensado, un tema que veremos en la próxima clase. Entre otras cosas, en el próximo post pondré videos de superfluidos escapándose espontáneamente de sus recipientes (¡seguro hay una película de ciencia ficción que se aprovecha de este fenómeno!).

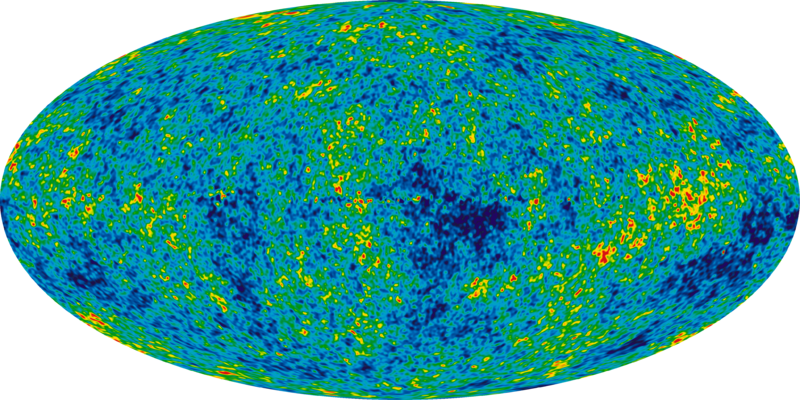

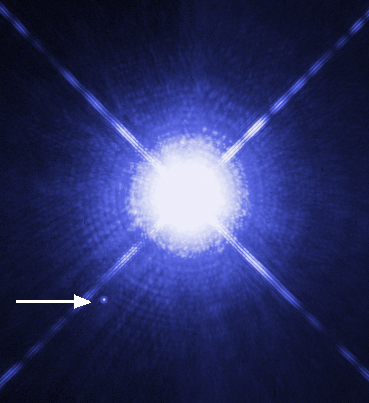

Pero antes de despedirnos, recuerden que el espacio es la frontera final. Hace unos pocos años la NASA consiguió generar un condensado de Bose-Einstein en el espacio (más precisamente, en la estación espacial internacional).

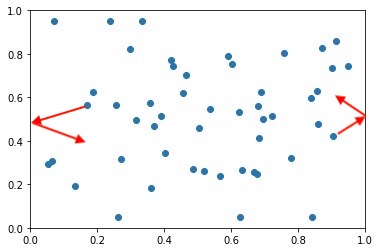

¿Para qué hicieron esto? Para poder realizar mediciones, en los experimentos se debe “soltar” al condensado: se apaga el potencial armónico que lo mantiene atrapado, y se deja que el gas se expanda libremente. En la Tierra, la gravedad hace que al liberar el condensado llegue un instante en el que esa nube de gas degenerado se separe en sus átomos originales, diferentes y con sus propias funciones de onda (es decir, los rolingas recuperan sus personalidades individuales, y luego del recital, vuelven a sus trabajos de oficina). La gravedad también pone un límite a cuán grande puede ser el condensado original, porque la gravedad hace eso: intenta tirar a las partículas para abajo. Como dice la canción de Charly García, la gravedad “te tira para atrás, te pide más y más, y llega a un punto en que no querés“. En este caso, el que no quiere más es el condensado. Pero sin gravedad (o en realidad, en la constante caída libre de la estación espacial internacional), se pueden armar condensados de Bose-Einstein más grandes, y medir por más tiempo mientras el gas se expande, manteniendo la bola de rolingas impersonales. En ausencia de gravedad, el salto del pogo dura más tiempo.

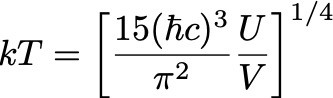

P.D.: Para los que sigan interesados en el problema de la masa de los fotones, en este link pueden encontrar un paper que describe las implicancias que tendría que los fotones tengan masa, cómo cambiarían las ecuaciones de Maxwell en esa situación, y una lista de los diversos experimentos que se han realizado para acotar la masa de los fotones. Hoy sabemos que si los fotones tuvieran masa, esa masa debe ser menor a 10-60 g (como referencia, la masa en reposo del electrón es de 9.1 x 10-28 g).